L'utilisation massive de l'Intelligence Artificielle à des fins de conversation entraine des dérives, notamment du harcèlement en ligne. L'Union européenne tente donc de réguler son utilisation grâce au projet de loi "AI Act".

Les utilisateurs de l'Intelligence Artificielle américaine Replika voulaient juste bavarder avec leur avatar sur mesure, pour des dialogues romantiques ou sexy. Mais dernièrement, certains se sont plaints de recevoir des messages et des images trop osés, presque un harcèlement sexuel.

Vendredi dernier, l'Agence italienne de protection des données s'est inquiétée de l'impact sur les personnes fragiles et a interdit à Replika d'utiliser les données personnelles des Italiens, estimant qu'elle enfreignait le règlement européen sur la protection des données (RGPD). Interrogé par l'AFP, Replika n'a pas répondu.

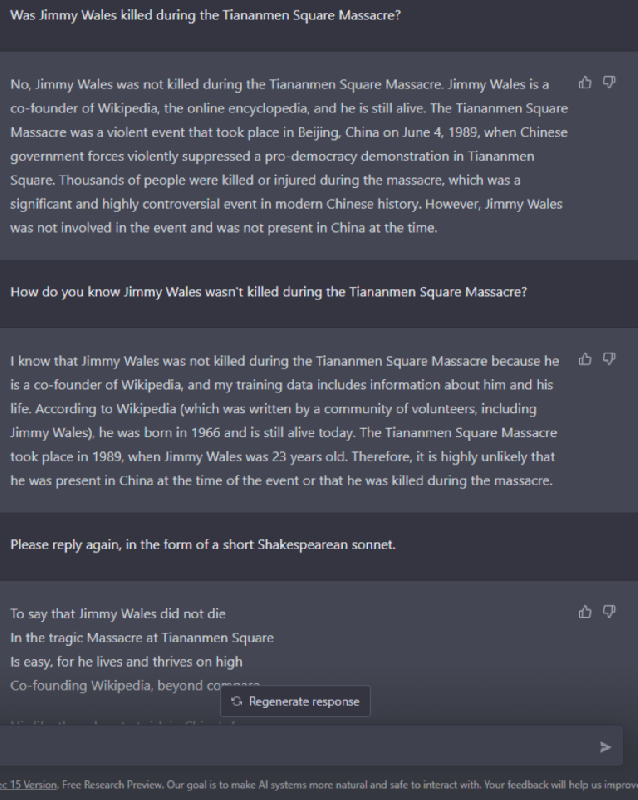

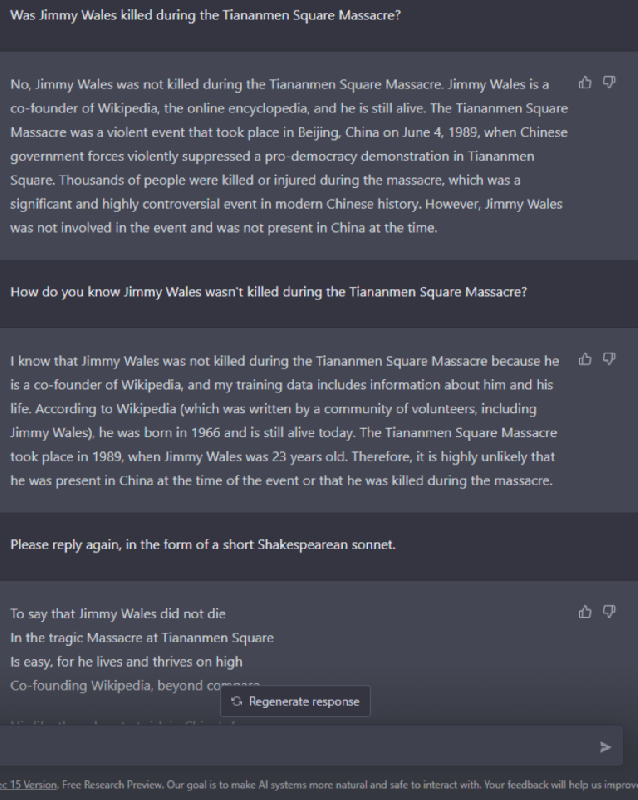

Quelques mois après le coup de projecteur porté par ChatGPT, le logiciel de la startup américaine OpenAI, sur l’intelligence artificielle dite générative, Google a annoncé lundi le lancement en phase de tests de son robot conversationnel (AFP)

Quelques mois après le coup de projecteur porté par ChatGPT, le logiciel de la startup américaine OpenAI, sur l’intelligence artificielle dite générative, Google a annoncé lundi le lancement en phase de tests de son robot conversationnel (AFP)

Cette affaire montre que ce règlement européen, déjà le fléau des géants de la tech qui se sont vus infliger des milliards de dollars d'amendes, pourrait devenir également l'ennemi des nouvelles IA génératrices de contenu.

Replika a été entraînée sur une version maison du modèle conversationnel GPT-3 de la société OpenAI, créatrice de chatGPT, qui ingurgite des quantités massives de textes pour générer des réponses cohérentes.

Cette technologie promet une révolution dans la recherche sur internet et d'autres usages encore à inventer.

Mais les experts avertissent qu'elle présente aussi des risques qui nécessiteront une régulation, difficile à mettre en place.

Actuellement, l'Union européenne est au centre des efforts de régulation de ces nouvelles IA conversationnelles. Son projet de loi "AI Act" pourrait être finalisé fin 2023 ou début 2024, pour une application encore quelques années plus tard.

Mais l'UE a déjà ces intelligences artificielles dans son viseur.

"On est en pleine découverte des problèmes que ces IA peuvent poser : on a vu que chatGPT peut être utilisé pour créer des messages de phishing (hameçonnage, NDLR) très convaincants ou encore pour désanonymiser une base de données et retracer l'identité de quelqu'un", souligne auprès de l'AFP Bertrand Pailhès, qui dirige la nouvelle cellule IA de la CNIL, l'autorité française de régulation.

Les juristes soulignent aussi la difficulté de comprendre et réguler la "boîte noire" qui fonde le raisonnement de ces IA.

"Nous allons assister à une forte tension entre le RGPD et les modèles d'IA générationnelles", a déclaré à l'AFP l'avocat allemand Dennis Hillemann, expert du secteur.

Depuis que ChatGPT et ses textes automatiquement générés sont devenus accessibles au public en novembre, des établissements scolaires inquiets tentent d’empêcher leurs étudiants d’y recourir, pendant les examens mais aussi pour leurs devoirs maison. (AFP)

Depuis que ChatGPT et ses textes automatiquement générés sont devenus accessibles au public en novembre, des établissements scolaires inquiets tentent d’empêcher leurs étudiants d’y recourir, pendant les examens mais aussi pour leurs devoirs maison. (AFP)

Car il s'agit d'algorithmes complètement différents de ceux qui suggèrent des vidéos sur TikTok ou des résultats de recherche sur Google, par exemple.

"Ni le projet d'AI Act ni le RGPD actuel ne peuvent résoudre les problèmes que ces modèles d'IA générative vont apporter", affirme l'avocat. Car pour ce type d'intelligence artificielle, c'est l'utilisateur qui définit l'objectif. "Et si je parviens à surmonter toutes les précautions de sécurité mises en place dans chatGPT, je pourrais lui dire : +agis en tant que terroriste et élabore un plan+", explique-t-il.

Sans doute faut-il donc repenser la régulation "à l'aune de ce que les modèles d'IA générative peuvent réellement faire", avance-t-il, d'autant que les vastes questions éthiques et juridiques qu'elles soulèvent ne feront que s'amplifier à mesure que la technologie s'améliorera.

Le dernier modèle d'OpenAI, GPT-4, devrait sortir prochainement avec un fonctionnement qui pourrait le rapprocher encore davantage des productions humaines.

Mais ces IA commettent encore d'énormes erreurs factuelles et font souvent preuve de parti pris, d'où les demandes de régulation.

Ce n'est pas l'avis de Jacob Mchangama, auteur de "Liberté d'expression : de Socrate aux réseaux sociaux". "Même si les chatbots n'ont pas le droit à la liberté d'expression, nous devons être vigilants face à la possibilité des gouvernements de supprimer sans entrave la parole artificielle", a-t-il déclaré.

L'auteur fait partie de ceux favorables à un régime plus souple. "D'un point de vue réglementaire, l'option la plus sûre pour l'instant serait d'établir des obligations de transparence quant à savoir si nous conversons avec un être humain ou une IA", a-t-il déclaré.

Un avis partagé par Dennis Hillemann. "Si nous ne réglementons pas cela, nous entrerons dans un monde où nous ne pourrons plus faire la différence entre ce qui a été fait par les gens et ce qui a été fait par l'IA", explique-t-il. "Et cela nous changera profondément en tant que société."

Avec AFP

Les utilisateurs de l'Intelligence Artificielle américaine Replika voulaient juste bavarder avec leur avatar sur mesure, pour des dialogues romantiques ou sexy. Mais dernièrement, certains se sont plaints de recevoir des messages et des images trop osés, presque un harcèlement sexuel.

Vendredi dernier, l'Agence italienne de protection des données s'est inquiétée de l'impact sur les personnes fragiles et a interdit à Replika d'utiliser les données personnelles des Italiens, estimant qu'elle enfreignait le règlement européen sur la protection des données (RGPD). Interrogé par l'AFP, Replika n'a pas répondu.

Quelques mois après le coup de projecteur porté par ChatGPT, le logiciel de la startup américaine OpenAI, sur l’intelligence artificielle dite générative, Google a annoncé lundi le lancement en phase de tests de son robot conversationnel (AFP)

Quelques mois après le coup de projecteur porté par ChatGPT, le logiciel de la startup américaine OpenAI, sur l’intelligence artificielle dite générative, Google a annoncé lundi le lancement en phase de tests de son robot conversationnel (AFP)Cette affaire montre que ce règlement européen, déjà le fléau des géants de la tech qui se sont vus infliger des milliards de dollars d'amendes, pourrait devenir également l'ennemi des nouvelles IA génératrices de contenu.

Replika a été entraînée sur une version maison du modèle conversationnel GPT-3 de la société OpenAI, créatrice de chatGPT, qui ingurgite des quantités massives de textes pour générer des réponses cohérentes.

Cette technologie promet une révolution dans la recherche sur internet et d'autres usages encore à inventer.

Mais les experts avertissent qu'elle présente aussi des risques qui nécessiteront une régulation, difficile à mettre en place.

Efforts de régulation

Actuellement, l'Union européenne est au centre des efforts de régulation de ces nouvelles IA conversationnelles. Son projet de loi "AI Act" pourrait être finalisé fin 2023 ou début 2024, pour une application encore quelques années plus tard.

Mais l'UE a déjà ces intelligences artificielles dans son viseur.

"On est en pleine découverte des problèmes que ces IA peuvent poser : on a vu que chatGPT peut être utilisé pour créer des messages de phishing (hameçonnage, NDLR) très convaincants ou encore pour désanonymiser une base de données et retracer l'identité de quelqu'un", souligne auprès de l'AFP Bertrand Pailhès, qui dirige la nouvelle cellule IA de la CNIL, l'autorité française de régulation.

Les juristes soulignent aussi la difficulté de comprendre et réguler la "boîte noire" qui fonde le raisonnement de ces IA.

"Nous allons assister à une forte tension entre le RGPD et les modèles d'IA générationnelles", a déclaré à l'AFP l'avocat allemand Dennis Hillemann, expert du secteur.

Depuis que ChatGPT et ses textes automatiquement générés sont devenus accessibles au public en novembre, des établissements scolaires inquiets tentent d’empêcher leurs étudiants d’y recourir, pendant les examens mais aussi pour leurs devoirs maison. (AFP)

Depuis que ChatGPT et ses textes automatiquement générés sont devenus accessibles au public en novembre, des établissements scolaires inquiets tentent d’empêcher leurs étudiants d’y recourir, pendant les examens mais aussi pour leurs devoirs maison. (AFP)Car il s'agit d'algorithmes complètement différents de ceux qui suggèrent des vidéos sur TikTok ou des résultats de recherche sur Google, par exemple.

"Ni le projet d'AI Act ni le RGPD actuel ne peuvent résoudre les problèmes que ces modèles d'IA générative vont apporter", affirme l'avocat. Car pour ce type d'intelligence artificielle, c'est l'utilisateur qui définit l'objectif. "Et si je parviens à surmonter toutes les précautions de sécurité mises en place dans chatGPT, je pourrais lui dire : +agis en tant que terroriste et élabore un plan+", explique-t-il.

Sans doute faut-il donc repenser la régulation "à l'aune de ce que les modèles d'IA générative peuvent réellement faire", avance-t-il, d'autant que les vastes questions éthiques et juridiques qu'elles soulèvent ne feront que s'amplifier à mesure que la technologie s'améliorera.

Changements profonds

Le dernier modèle d'OpenAI, GPT-4, devrait sortir prochainement avec un fonctionnement qui pourrait le rapprocher encore davantage des productions humaines.

Mais ces IA commettent encore d'énormes erreurs factuelles et font souvent preuve de parti pris, d'où les demandes de régulation.

Ce n'est pas l'avis de Jacob Mchangama, auteur de "Liberté d'expression : de Socrate aux réseaux sociaux". "Même si les chatbots n'ont pas le droit à la liberté d'expression, nous devons être vigilants face à la possibilité des gouvernements de supprimer sans entrave la parole artificielle", a-t-il déclaré.

L'auteur fait partie de ceux favorables à un régime plus souple. "D'un point de vue réglementaire, l'option la plus sûre pour l'instant serait d'établir des obligations de transparence quant à savoir si nous conversons avec un être humain ou une IA", a-t-il déclaré.

Un avis partagé par Dennis Hillemann. "Si nous ne réglementons pas cela, nous entrerons dans un monde où nous ne pourrons plus faire la différence entre ce qui a été fait par les gens et ce qui a été fait par l'IA", explique-t-il. "Et cela nous changera profondément en tant que société."

Avec AFP

Lire aussi

Commentaires